如何理解Adam算法 (Adaptive Moment Estimation)? - 知乎

Adam算法现在已经算很基础的知识,就不多说了。 3. 鞍点逃逸和极小值选择 这些年训练神经网络的大量实验里,大家经常观察到,Adam的training loss下降得比SGD更快,但是test accuracy却经常 …

Adam and Eve - Biblical Archaeology Society

Mar 6, 2025 · In a BAS Library special collection of articles, learn about a controversial interpretation of the creation of woman, and explore other themes related to Adam

如何理解Adam算法 (Adaptive Moment Estimation)? - 知乎

Adam优化算法 (Adam Gradient Descent Optimizer, AGDO) 是一种新型的元启发式算法(智能优化算法),作者受到Adam优化器的启发,使用三条规则探索整个搜索过程:渐进梯度动量积分、动态梯度 …

如何理解Adam算法 (Adaptive Moment Estimation)? - 知乎

Adam算法现在已经算很基础的知识,就不多说了。 3. 鞍点逃逸和极小值选择 这些年训练神经网络的大量实验里,大家经常观察到,Adam的training loss下降得比SGD更快,但是test accuracy却经常 …

adam 算法在机器学习中的作用是什么? - 知乎

Jan 10, 2024 · Adam算法是一种基于梯度下降的优化算法,通过调整模型参数以最小化损失函数,从而优化模型的性能。 Adam算法结合了动量(Momentum)和RMSprop(Root Mean Square …

adam算法原理和推导过程? - 知乎

三、Adam优化算法的基本机制 Adam 算法和传统的随机梯度下降不同。随机梯度下降保持单一的学习率(即 alpha)更新所有的权重,学习率在训练过程中并不会改变。而 Adam 通过计算梯度的***一阶 …

- Biblical Archaeology Society

Nov 27, 2025 · The Adam and Eve story states that God formed Adam out of dust, and then Eve was created from one of Adam’s ribs. Was it really his rib?

如何调整 Adam 默认参数以提高深度学习模型的收敛速度? - 知乎

以下是一些调整 Adam 默认参数的方法,以提高深度学习模型的收敛速度: 调整学习率(learning rate): Adam 算法的默认学习率为 0.001,但是对于一些模型,这个值可能太小或者太大。

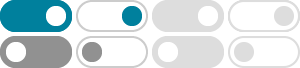

机器学习2 -- 优化器(SGD、SGDM、Adagrad、RMSProp、Adam)

Apr 6, 2024 · Adam是SGDM和RMSProp的结合,它基本解决了之前提到的梯度下降的一系列问题,比如随机小样本、自适应学习率、容易卡在梯度较小点等问题,2015年提出。

BP算法与深度学习主流优化器(Adam,RMSprop等等)的区别是什么?

BP算法与深度学习主流优化器(Adam,RMSprop等等)的区别是什么? 最近在研究深度学习,之前对神经网络有所了解,知道BP之于神经网络的地位,但是深度学习的模型中却很少用到BP算法去训练模 …